Poisonify — AI defense для музыкантов

пока мы наслаждались возможностью без каких-либо навыков создавать музыку в Suno или картины в MidJourney, музыканты и художники, на чьих работах эти модели обучали без их согласия, энтузиазм не разделяют. каждая из впечатливших вас нейросетей обучалась по сути на пиратском конетенте, который тупо спарсили в интернете. иначе chatGPT не знал бы ничего про Гарри Поттера, Suno про Дэвида Боуи и так далее. под давлением крупных издательств, ИИ компании либо заключают лицензионные соглашения, либо ставят на выход моделей дополнительный фильтр, запрещающий им пропускать изображения в стиле художника Х или песни в духе У. при этом из датасетов эти данные, конечно, никто не удаляет, и что либо доказать практически невозможно

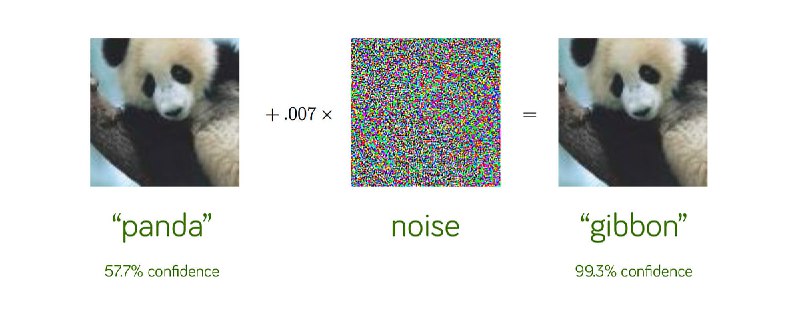

при этом оказалось для каждой из нейросетей можно подобрать свою adversarial attack — наложение на входной сигнал специального шума, незаметного для человека, но тотально сбивающего с толка алгоритмы. в этой статье Ian Goodfellow показали, что наложение шума на фото панды, сбивает путает классификатор (фото). и надежной защиты от таких атак до сих пор не придумали

баланс сил в битве вокруг копирайта с большим перевесом был на стороне технологических компаний, но в этом видео музыкант, ютубер и гик Benn Jordan нанес может и небольшой, но очень красивый ответный удар.

работа сделана в коллабе рисерчерами, которые выпустили статью Harmony Cloak о подходе к зашумлению музыки специальным adversarial noise, таким образом, что

1) из нее сложнее извлечь паттерны, копируя стиль, защищая музыкантов от обучения на их музыке

2) который и вовсе может вовсе может испортить весь обучающий датасет (хотя к этому утверждению много вопросов)

запасаюсь попкорном

#ai_safety #music

пока мы наслаждались возможностью без каких-либо навыков создавать музыку в Suno или картины в MidJourney, музыканты и художники, на чьих работах эти модели обучали без их согласия, энтузиазм не разделяют. каждая из впечатливших вас нейросетей обучалась по сути на пиратском конетенте, который тупо спарсили в интернете. иначе chatGPT не знал бы ничего про Гарри Поттера, Suno про Дэвида Боуи и так далее. под давлением крупных издательств, ИИ компании либо заключают лицензионные соглашения, либо ставят на выход моделей дополнительный фильтр, запрещающий им пропускать изображения в стиле художника Х или песни в духе У. при этом из датасетов эти данные, конечно, никто не удаляет, и что либо доказать практически невозможно

при этом оказалось для каждой из нейросетей можно подобрать свою adversarial attack — наложение на входной сигнал специального шума, незаметного для человека, но тотально сбивающего с толка алгоритмы. в этой статье Ian Goodfellow показали, что наложение шума на фото панды, сбивает путает классификатор (фото). и надежной защиты от таких атак до сих пор не придумали

баланс сил в битве вокруг копирайта с большим перевесом был на стороне технологических компаний, но в этом видео музыкант, ютубер и гик Benn Jordan нанес может и небольшой, но очень красивый ответный удар.

работа сделана в коллабе рисерчерами, которые выпустили статью Harmony Cloak о подходе к зашумлению музыки специальным adversarial noise, таким образом, что

1) из нее сложнее извлечь паттерны, копируя стиль, защищая музыкантов от обучения на их музыке

2) который и вовсе может вовсе может испортить весь обучающий датасет (хотя к этому утверждению много вопросов)

запасаюсь попкорном

#ai_safety #music

tg-me.com/levels_of_abstraction/98

Create:

Last Update:

Last Update:

Poisonify — AI defense для музыкантов

пока мы наслаждались возможностью без каких-либо навыков создавать музыку в Suno или картины в MidJourney, музыканты и художники, на чьих работах эти модели обучали без их согласия, энтузиазм не разделяют. каждая из впечатливших вас нейросетей обучалась по сути на пиратском конетенте, который тупо спарсили в интернете. иначе chatGPT не знал бы ничего про Гарри Поттера, Suno про Дэвида Боуи и так далее. под давлением крупных издательств, ИИ компании либо заключают лицензионные соглашения, либо ставят на выход моделей дополнительный фильтр, запрещающий им пропускать изображения в стиле художника Х или песни в духе У. при этом из датасетов эти данные, конечно, никто не удаляет, и что либо доказать практически невозможно

при этом оказалось для каждой из нейросетей можно подобрать свою adversarial attack — наложение на входной сигнал специального шума, незаметного для человека, но тотально сбивающего с толка алгоритмы. в этой статье Ian Goodfellow показали, что наложение шума на фото панды, сбивает путает классификатор (фото). и надежной защиты от таких атак до сих пор не придумали

баланс сил в битве вокруг копирайта с большим перевесом был на стороне технологических компаний, но в этом видео музыкант, ютубер и гик Benn Jordan нанес может и небольшой, но очень красивый ответный удар.

работа сделана в коллабе рисерчерами, которые выпустили статью Harmony Cloak о подходе к зашумлению музыки специальным adversarial noise, таким образом, что

1) из нее сложнее извлечь паттерны, копируя стиль, защищая музыкантов от обучения на их музыке

2) который и вовсе может вовсе может испортить весь обучающий датасет (хотя к этому утверждению много вопросов)

запасаюсь попкорном

#ai_safety #music

пока мы наслаждались возможностью без каких-либо навыков создавать музыку в Suno или картины в MidJourney, музыканты и художники, на чьих работах эти модели обучали без их согласия, энтузиазм не разделяют. каждая из впечатливших вас нейросетей обучалась по сути на пиратском конетенте, который тупо спарсили в интернете. иначе chatGPT не знал бы ничего про Гарри Поттера, Suno про Дэвида Боуи и так далее. под давлением крупных издательств, ИИ компании либо заключают лицензионные соглашения, либо ставят на выход моделей дополнительный фильтр, запрещающий им пропускать изображения в стиле художника Х или песни в духе У. при этом из датасетов эти данные, конечно, никто не удаляет, и что либо доказать практически невозможно

при этом оказалось для каждой из нейросетей можно подобрать свою adversarial attack — наложение на входной сигнал специального шума, незаметного для человека, но тотально сбивающего с толка алгоритмы. в этой статье Ian Goodfellow показали, что наложение шума на фото панды, сбивает путает классификатор (фото). и надежной защиты от таких атак до сих пор не придумали

баланс сил в битве вокруг копирайта с большим перевесом был на стороне технологических компаний, но в этом видео музыкант, ютубер и гик Benn Jordan нанес может и небольшой, но очень красивый ответный удар.

работа сделана в коллабе рисерчерами, которые выпустили статью Harmony Cloak о подходе к зашумлению музыки специальным adversarial noise, таким образом, что

1) из нее сложнее извлечь паттерны, копируя стиль, защищая музыкантов от обучения на их музыке

2) который и вовсе может вовсе может испортить весь обучающий датасет (хотя к этому утверждению много вопросов)

запасаюсь попкорном

#ai_safety #music

BY уровни абстракции

Share with your friend now:

tg-me.com/levels_of_abstraction/98